| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |

- adfit

- unity

- 2D Camera

- 커스텀 패키지

- Tween

- ui

- Job 시스템

- 직장인자기계발

- 최적화

- 직장인공부

- TextMeshPro

- 패스트캠퍼스후기

- 오공완

- 프레임워크

- Framework

- 패스트캠퍼스

- 암호화

- 환급챌린지

- 샘플

- job

- 가이드

- Dots

- DotsTween

- RSA

- base64

- AES

- C#

- sha

- Unity Editor

- Custom Package

- Today

- Total

EveryDay.DevUp

패스트캠퍼스 환급챌린지 49일차 : Part5. 강화학습 본문

패스트캠퍼스 환급챌린지 49일차 : Part5. 강화학습

EveryDay.DevUp 2025. 4. 22. 21:50본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

https://bit.ly/4hTSJNB

🎉누적 구매수 111만 건 돌파 감사제 100% 페이백 (04.21 - 04.26) | 패스트캠퍼스

통 크게! 전 구매 고객께 결제 금액을 100% 돌려드립니다!

fastcampus.co.kr

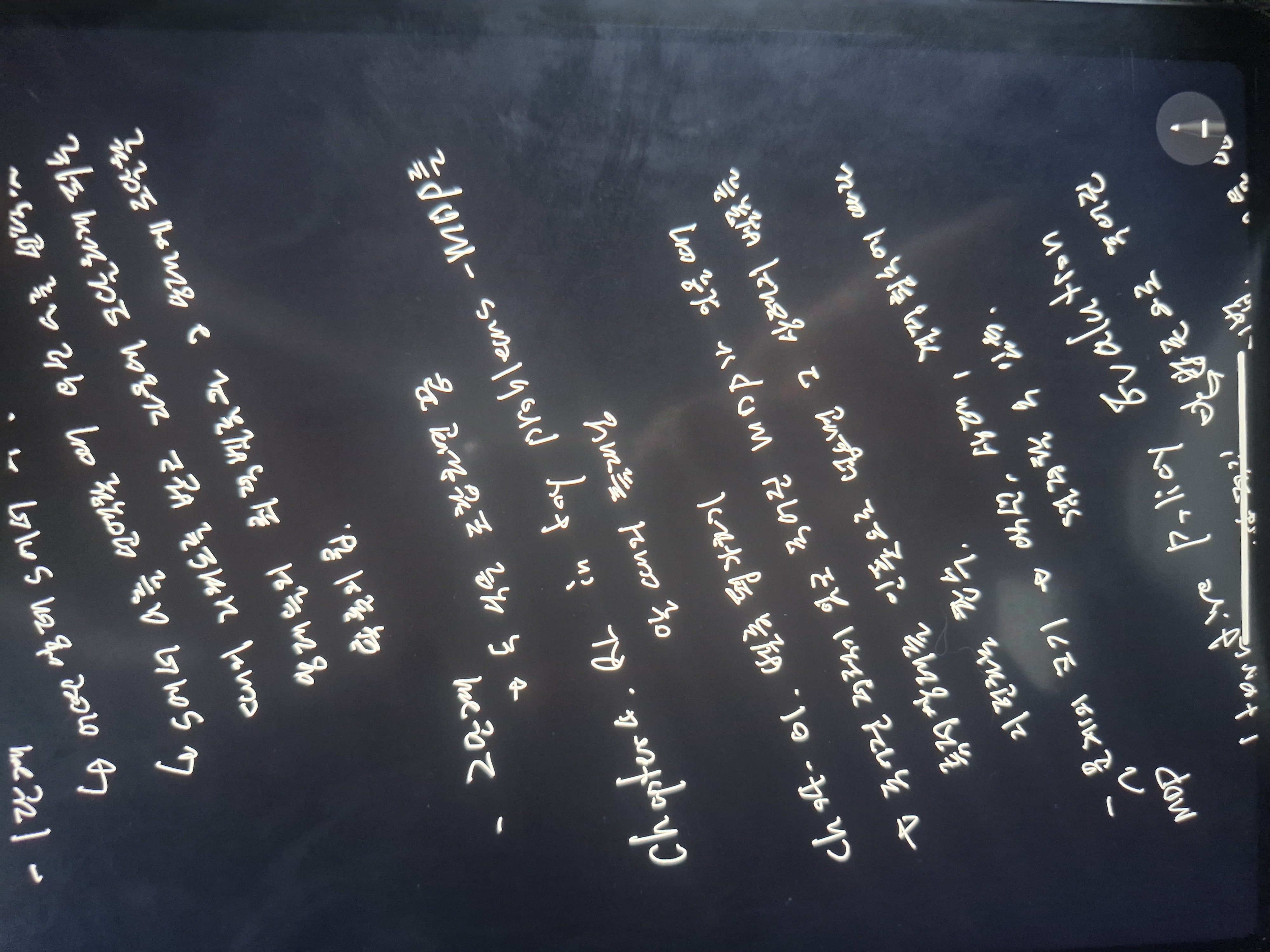

Ch03.Introduction to RL 벨만 방정식

- 대부분의 강화학습읔 벨류를 구하는 것에서 출발하는데, 벨류를 구하기 위한 뼈대가 되는 수식이 벨만 방정식

Ch03-01 벨만 기대 방정식 0단계

- 벨류 사이의 재귀적 관계를 구하는 식

- 현재 상태의 벨류는 리워드를 하나 받고 그 다음 상태의 벨류를 더한 것과 같음

Ch03-02 벨만방정식 1,2 단계

- 1단계의 수식은 정책에 의한 확률을 구하는 식과 전위 확률에 의한 확률을 구하는 식으로 만들어짐

- 2단계의 수식은 1단계의 수식을 대입하여 계사하는 것

- 전위 확률을 모를 때는 0단계의 식을 사용하고 전위 확률응 알 때는 2단계의 수식을 사용함

Ch03-03 벨만 최적 방정식 0단계

- 최적 벨류의 재귀적 관계에 대한 식

: 최적 벨류 => 어떤 MDP가 주어졌을 때, 그 MDP안에 존재라는 모든 정책 중 가장 좋은 정책을 선택하여 계산한 상태의 벨류

: 가장 좋은 정책은 모든 상태에 대해 비교할 수 있을 때 가장 큰 벨류를 선택하는 것

Ch03-04 벨만 방정식 1, 2단계

- 1단계

: 어떤 상태 S에서 최대 벨류를 선택

: 특정 상태에서 액션를 선택할 때, 액션을 선택했을 때의 리워드를 받고 다음에 도달하게 되는 상태들의 최적 벨류와 그 상태에 도달할 확률의 곱

- 2단계

: 1단계의 수식을 대입하여 계산

Ch04 RL in toy problems - MDP를 알 때의 플래닝

Ch04-01 벨류 평가하기

- 주어진 정책이 있고 주어진 MDP가 있을 때 특정 상태를 인풋으로 넣으면 그 상태의 벨류를 리턴하는 함수

- MDP 문제의 크기

: 액션, 상태, 결정 횟수에 따라 결정할 수 있음

- iterative policy evalution

- 어떤 반복적인 방법론으로 주어진 정책을 평가하는 방법

1) 상태별 빈칸을 뚫어 놓은 테이블을 생성하여 임의의 값으로 테이블을 초기화

2) 벨만 방정식을 이용하여 값을 업데이트

3) 2의 과정을 반복하여 값을 업데이트하면 정답값을 구할 수 있음

'패스트캠퍼스 > 딥러닝·인공지능Signature초격차패키지Online' 카테고리의 다른 글

| 패스트캠퍼스 환급챌린지 51일차 : Part5. 강화학습 (0) | 2025.04.24 |

|---|---|

| 패스트캠퍼스 환급챌린지 50일차 : Part5. 강화학습 (0) | 2025.04.23 |

| 패스트캠퍼스 환급챌린지 48일차 : Part5. 강화학습 (0) | 2025.04.21 |

| 패스트캠퍼스 환급챌린지 47일차 : Part5. 강화학습 (0) | 2025.04.20 |

| 패스트캠퍼스 환급챌린지 46일차 : Part4. 인공지능의 이해 Lv3 : 인공지능을 바탕으로한 실습 (0) | 2025.04.19 |