| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- ui

- TextMeshPro

- Framework

- 샘플

- Unity Editor

- 직장인자기계발

- 가이드

- RSA

- Tween

- sha

- DotsTween

- AES

- 패스트캠퍼스

- 프레임워크

- 최적화

- 직장인공부

- base64

- job

- 2D Camera

- 암호화

- 환급챌린지

- 커스텀 패키지

- Dots

- adfit

- Custom Package

- 오공완

- C#

- 패스트캠퍼스후기

- unity

- Job 시스템

- Today

- Total

EveryDay.DevUp

패스트캠퍼스 환급챌린지 48일차 : Part5. 강화학습 본문

패스트캠퍼스 환급챌린지 48일차 : Part5. 강화학습

EveryDay.DevUp 2025. 4. 21. 21:41본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

https://bit.ly/4hTSJNB

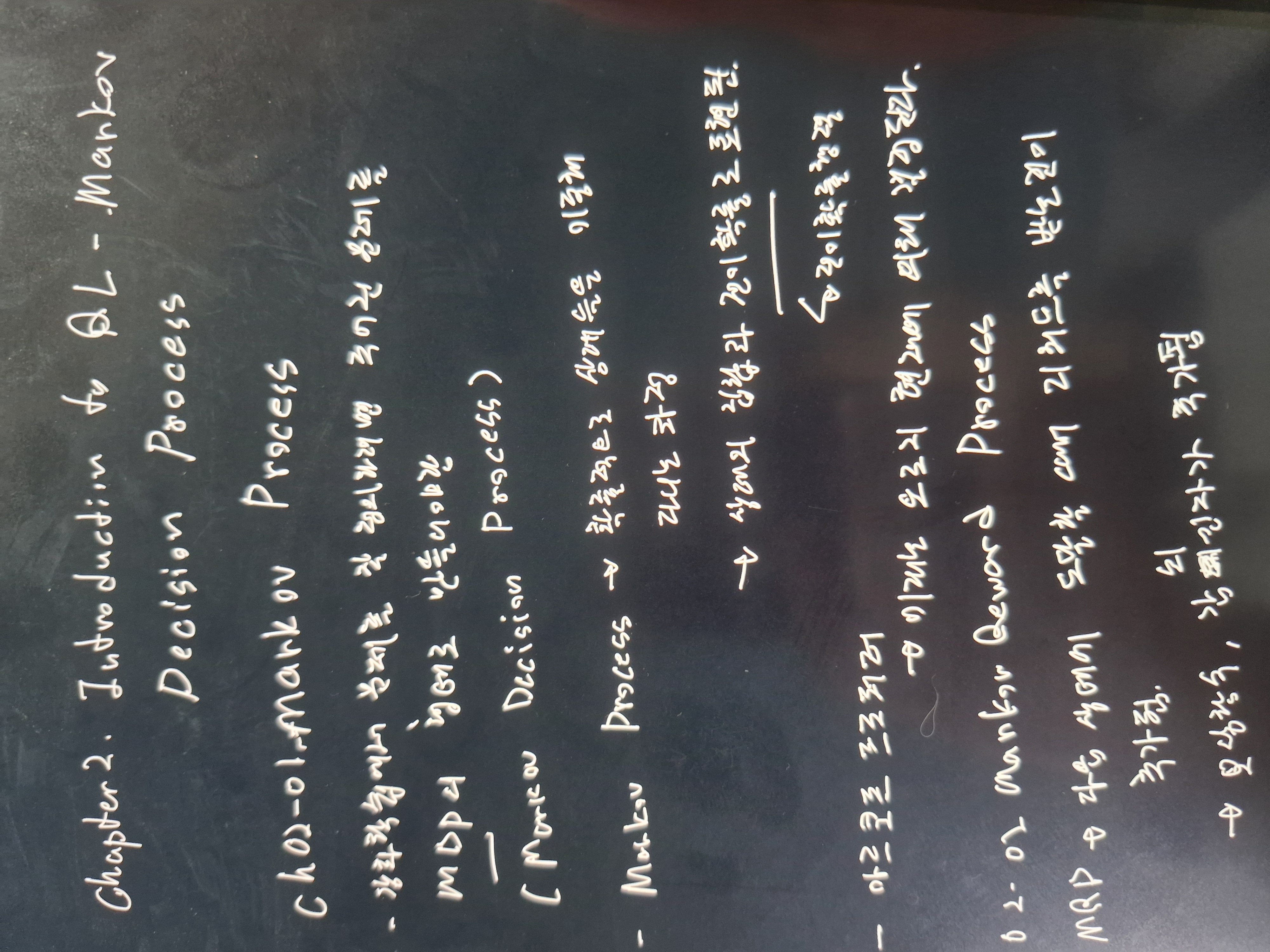

Chapter02. Introduction RL - Markov Desision Process

- 강화학습에서 문제를 잘 정의하려면 주어진 문제를 MDP의 형태로 만들어야함

Ch02-01 Markov Process

- 확률적으로 상태를 이동해 다니는 과정

- 상태의 집합과 전이 확률 (전이 확률 행렬)로 표현됨

- 마르코프 프로퍼티

: 미래는 오로지 현재에 의해 결정됨

: Markov Process 는 마르코프 프로퍼티 정의를 반영한 것

Ch02-02 Markov Reward Process

- Markov Process에서 다음 상태에 도달할 때 리워드를 받는 것이 추가됨

- 보상을 위한 보상 함수와 감쇠 인자가 추가됨

- 감쇠된 보상의 합 리턴

: 감쇠된 미래 리워드의 합

: 강화학습은 리턴을 최대화하는 과정

- 감쇠를 왜 필요한가

: 무한에 수렴하는 것을 방지하기 위한 수학적 편의성

: 금융에서의 적합성

: 사람의 선호 반영 => 미래의 가치를 반영

- 리턴의 정의 이유

: 어떤 상태에 Value를 측정하는데 중요한 의미

: 감마는 0~1 사이의 값을 가지며 1에 가까울 수록 미래를 보정하게 됨

=> 감마를 n승하기 때문에 점점 작아짐으로 미래의 상태에 대한 보정이 1의 값에 가까울 수록 보상에 많이 반영됨

Ch02-03 Markov Decision Process

- Markov Reward Process에서 액션이 추가됨

- 에이전트이 액션에 따라서 다음 상태가 달라짐

- MRP와의 차이점

: 전이 확률이 달라짐 => 현재 상태에서 액션를 했을 때 다음 상태에 도달할 확률

: 보상함수가 달라짐 => 현다 상태에서의 액션을 선택했을 때 보상에 기대값

1) Policy

- 에이전트가 MDP안에서 어떤 정책을 가지고 움직릴 것인가

- 현재 상태에서 특정 액션을 선택할 확률

2) Value

- 어느 상태가 얼만큼 좋은가

- Policy가 정해져있어야 함

- 특정 상태에서 시작해 끝까지 움직일 때 얻게 될 리턴의 기대값

3) Action Value

- 현대 상태에서 액션를 선택하고 이후에 정책을 이용해 끝까지 움직일 때 얻게 될 리턴의 기대 값

'패스트캠퍼스 > 딥러닝·인공지능Signature초격차패키지Online' 카테고리의 다른 글

| 패스트캠퍼스 환급챌린지 50일차 : Part5. 강화학습 (0) | 2025.04.23 |

|---|---|

| 패스트캠퍼스 환급챌린지 49일차 : Part5. 강화학습 (0) | 2025.04.22 |

| 패스트캠퍼스 환급챌린지 47일차 : Part5. 강화학습 (0) | 2025.04.20 |

| 패스트캠퍼스 환급챌린지 46일차 : Part4. 인공지능의 이해 Lv3 : 인공지능을 바탕으로한 실습 (0) | 2025.04.19 |

| 패스트캠퍼스 환급챌린지 45일차 : Part4. 인공지능의 이해 Lv3 : 인공지능을 바탕으로한 실습 (0) | 2025.04.18 |