| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- Tween

- Job 시스템

- job

- 오공완

- 직장인자기계발

- DotsTween

- AES

- Dots

- 패스트캠퍼스

- 가이드

- 샘플

- Framework

- 2D Camera

- adfit

- 패스트캠퍼스후기

- Unity Editor

- 프레임워크

- unity

- sha

- 최적화

- Custom Package

- RSA

- base64

- C#

- 환급챌린지

- TextMeshPro

- 암호화

- 커스텀 패키지

- ui

- 직장인공부

- Today

- Total

EveryDay.DevUp

패스트캠퍼스 환급챌린지 55일차 : Part5. 강화학습 본문

패스트캠퍼스 환급챌린지 55일차 : Part5. 강화학습

EveryDay.DevUp 2025. 4. 28. 20:25본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

https://bit.ly/4hTSJNB

커리어 성장을 위한 최고의 실무교육 아카데미 | 패스트캠퍼스

성인 교육 서비스 기업, 패스트캠퍼스는 개인과 조직의 실질적인 '업(業)'의 성장을 돕고자 모든 종류의 교육 콘텐츠 서비스를 제공하는 대한민국 No. 1 교육 서비스 회사입니다.

fastcampus.co.kr

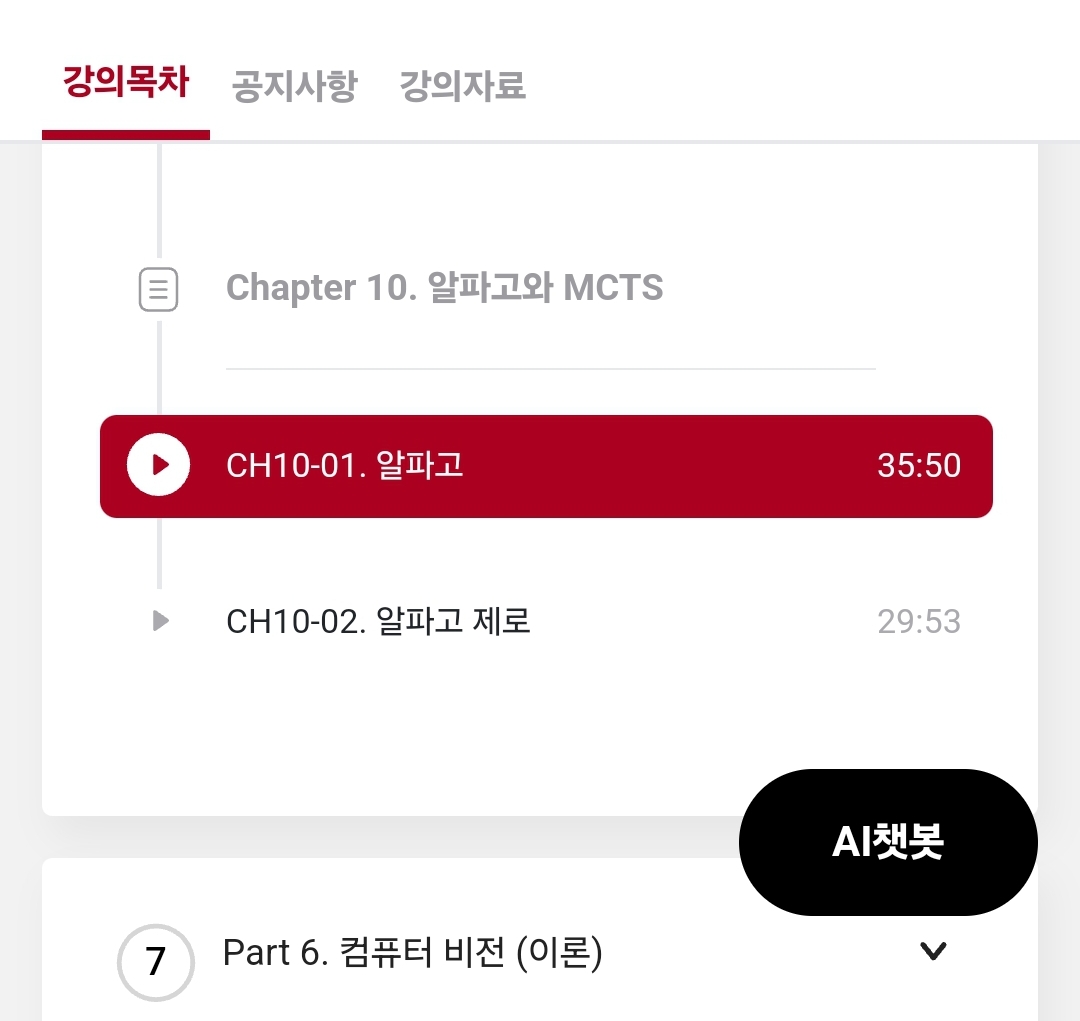

Chapter 10. 알파고와 MCTS

Ch10-01 알파고

- 바둑에서의 상태는 10^180

1) MCTS

- 현재 상황에 특화된 솔루션

: 수 많은 상태를 저장해서 수를 둔다기보다는 이미 학습된 데이터를 바탕으로 현재 상태에서 두었을 때 가장 좋은 선택을 하게 됨

: 수 많은 상태 후보에서 선택을 하면 해당 선택 외의 후보들은 트리에서 없어진다고 보면 됨

- 알파고는 MCTS를 돌리는 프로그램

- 컴퓨터 여러대가 힘을 합쳐서 수행

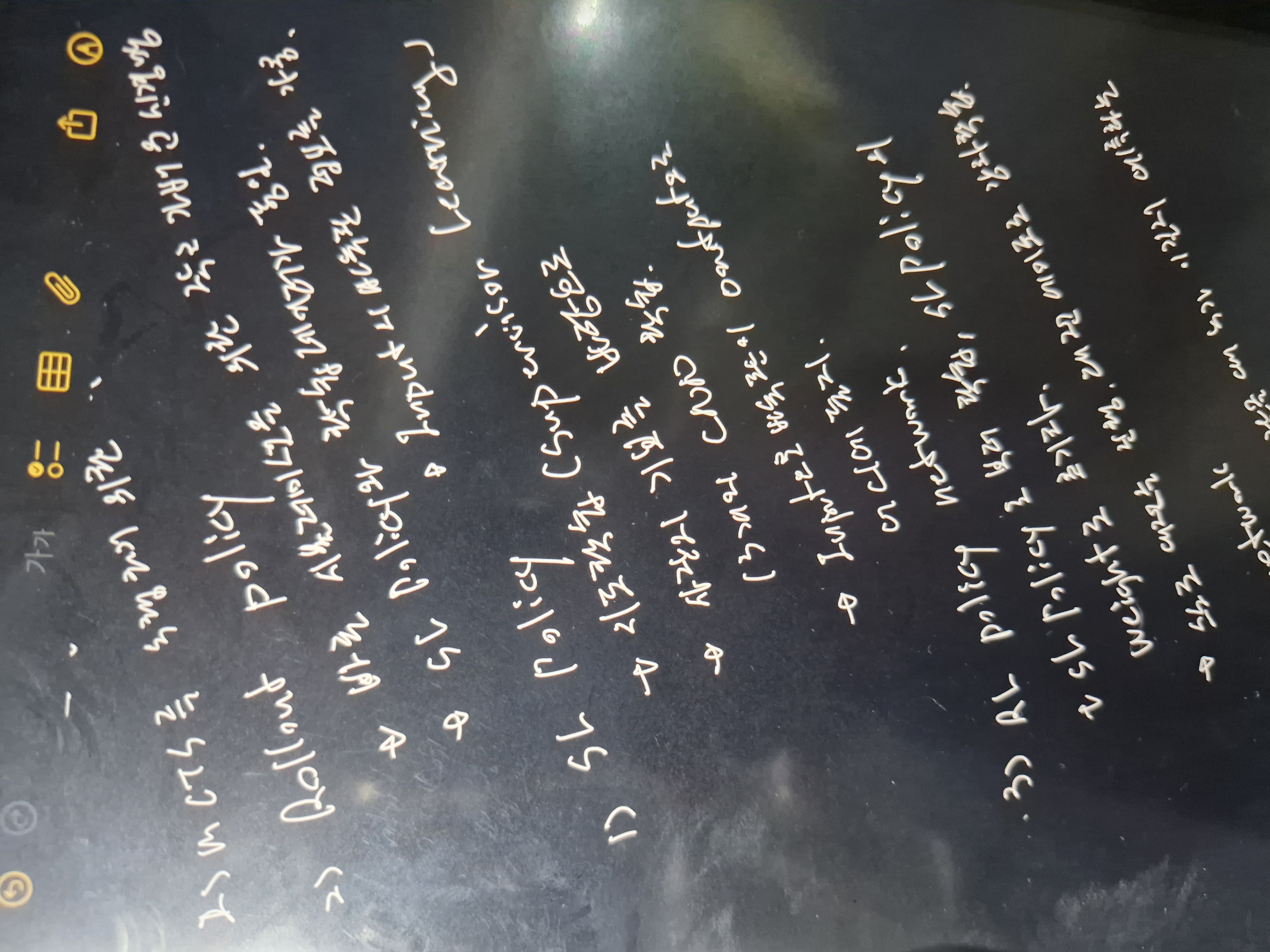

2) MCTS 수행을 위한 4가지 신경망

ㄱ. SL Policy

: 사람의 기보를 바탕으로 13개의 CNN학습을 하는 지도학습

: Input으로 바둑판 정보를 Output으로 어디에 둘지를 결정

ㄴ. Rollout Policy

: 빠른 시뮬레이션를 위한 작고 가벼운 신경망

: SL Policy와 같은 학습 데이터를 사용, 단 Input의 바둑판 정보는 가공함

ㄷ. RL Policy 네트워크

: SL Policy로 부터 학습하여 초기에는 같은 웨이트 값을 사용함

: 스스로 대전을 진행해서 대전응 통해 강화학습을 진행함

ㄹ. Value 네트워크

: RL Policy 를 따랏을 때 누가 이길지 예측하는 네트워크

3) MCTS 프로세스

: 현재 상태에서 좋은 수를 하나 고름

: 좋은 수란?

-> 해봤더니 얼마나 좋은가 = value network + rollout 으로 게임을 끝까지 했을 때의 결과를 보상으로 계산함

-> 해보기 전에 얼마나 좋은가 = SL Policy 로 부터 보상 정보를 계산함

-> 위의 두 개를 더했을 때의 값이 큰 수를 둠

Ch10-02 알파고 제로

- 사람의 지식을 사용하지 않음 = 사람의 기보를 사용하지 않음

: 사람의 지도로 학습 된 ai는 사람을 뛰어넘기 어려움

- MCTS를 선생님으로 둠

: MCTS 끼리 수많은 대전를 하면서 학습을 진행하게 됨

- 학습의 과정

: 매 스테이트마다 MCTS를 통해 정책을 계산하고 액션을 샘플링

: 게임이 끝날 때까지 반복하고 최종적인 보상을 결정함

'패스트캠퍼스 > 딥러닝·인공지능Signature초격차패키지Online' 카테고리의 다른 글

| 패스트캠퍼스 환급챌린지 56일차 : Part6.컴퓨터 비전(이론) (1) | 2025.04.29 |

|---|---|

| 패스트캠퍼스 환급챌린지 52일차 : Part5. 강화학습 (0) | 2025.04.25 |

| 패스트캠퍼스 환급챌린지 51일차 : Part5. 강화학습 (0) | 2025.04.24 |

| 패스트캠퍼스 환급챌린지 50일차 : Part5. 강화학습 (0) | 2025.04.23 |

| 패스트캠퍼스 환급챌린지 49일차 : Part5. 강화학습 (0) | 2025.04.22 |