| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |

- base64

- adfit

- 직장인공부

- 최적화

- 커스텀 패키지

- ui

- unity

- RSA

- 암호화

- Dots

- C#

- Tween

- 2D Camera

- sha

- TextMeshPro

- 패스트캠퍼스후기

- 프레임워크

- AES

- Unity Editor

- 직장인자기계발

- job

- 패스트캠퍼스

- 환급챌린지

- 가이드

- 샘플

- Job 시스템

- Framework

- Custom Package

- 오공완

- DotsTween

- Today

- Total

EveryDay.DevUp

패스트캠퍼스 환급챌린지 29일차 : Part3. 인공지능의 이해 Lv2 : 숲을 보는 인공지능 본문

패스트캠퍼스 환급챌린지 29일차 : Part3. 인공지능의 이해 Lv2 : 숲을 보는 인공지능

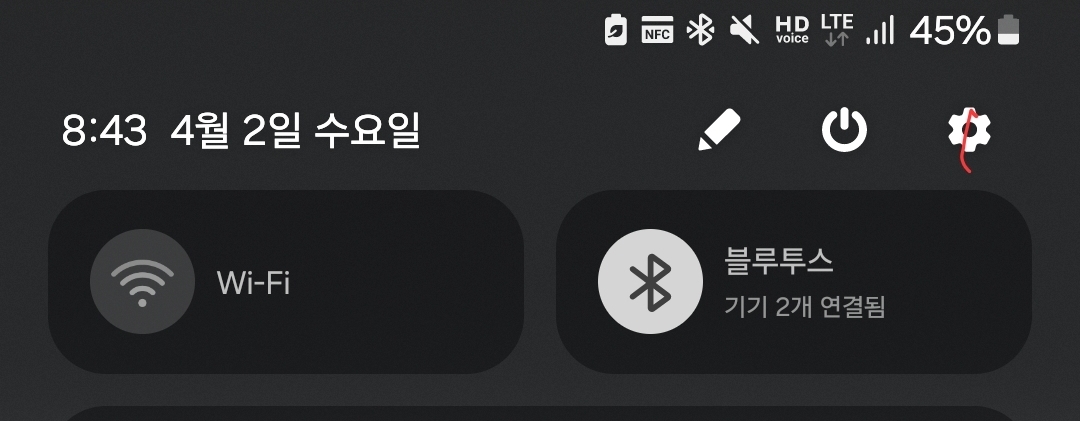

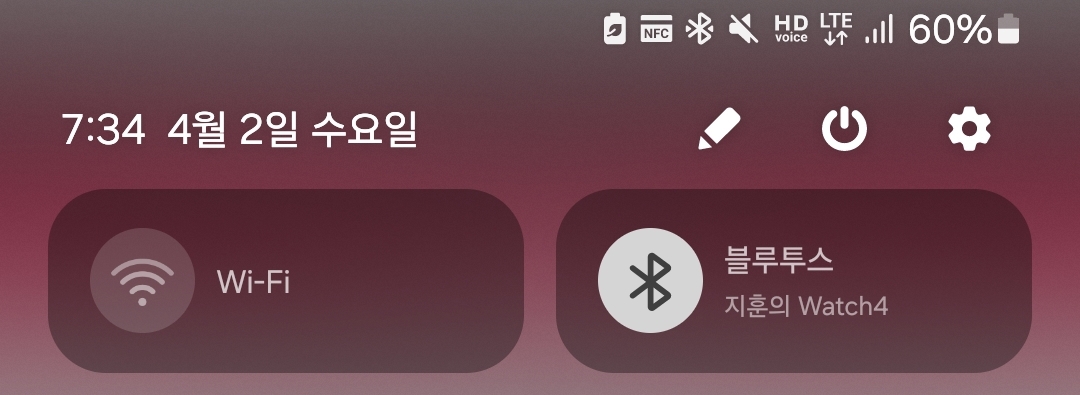

EveryDay.DevUp 2025. 4. 2. 22:46본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

https://bit.ly/4hTSJNB

커리어 성장을 위한 최고의 실무교육 아카데미 | 패스트캠퍼스

성인 교육 서비스 기업, 패스트캠퍼스는 개인과 조직의 실질적인 '업(業)'의 성장을 돕고자 모든 종류의 교육 콘텐츠 서비스를 제공하는 대한민국 No. 1 교육 서비스 회사입니다.

fastcampus.co.kr

Ch03-01 분류 알고리즘의 유형별 특징 정리 (Tree 계열의 알고리즘)

1) 의사 결정 트리 분류

- 데이터를 특정 기준 값을 가지고 판단 후 내려가면서, 순도가 높아지는 결정을 하는 방법

- 학습 데이터에 오버 피팅되기 쉬운 단점이 존재함

2) 랜덤포레스트 (앙상블 모델)

- 여러개의 의사 결정 트리를 통해서 하나만 사용했을 때의 단점을 개선

- 높은 정확도와 많은 개수의 독립 변수를 다룰 수 있지만, 연산 시간이 오래걸릴 수 있음

3) Bagging

- 랜덤 샘플링을 통해 여러개의 분류기를 만들고 보팅을 통해 결과를 얻는 방법

- 하드 보팅은 다수결에 따라 결정하고, 소프트 포팅은 다수의 분류기의 최종 확률을 평균하여 결정함

4) 부스팅

- 오류가 발생한 데이터에 가중치를 줘서, 다시 학습할 수 있도록 함

5) 하이퍼 파라미터

- 학습 과정을 제어하는데 사용하는 변수

- 트리의 하이퍼 파라미터 종류

ㄱ. criterion : 가지 분할의 성능을 평가할 때 사용하는 알고리즘

ㄴ. max feature : 의사 결정 트리의 노드 분할을 위한 최대 피처수

ㄷ. max leap node : 최종 노드의 최대 개수

ㄹ. max depth : 나무의 깊이, 깊어질 수록 오버피팅이 발생하는 경우가 생김

6) 트리 형태의 장점

- 모델의 최종 결과의 과정을 확인하기 쉬움, 성능을 높이기 위해 앙상블/보팅방법/노드 분할 조건의 조정이 필요함

Ch03-02 분류 알고리즘의 유형별 특징 정리 (SVM, KNN)

1) KNN (K-nearest neighbor)

- 그룹 A,B가 있을 때 새로운 데이터 C가 추가될 경우, 어느 그룹에 속할 지를 해당 데이터가 추가된 위치를 기준으로 주변 데이터의 위치와 비교하여 K개 근처를 기준으로 설정함 (K = 하이퍼 파라미터)

2) SVM (Support Vector Machine)

- A,B 요소를 분류할 수 있는 최적의 선, 주어진 많은 데이터를 가능한 멀리 떨어질 수 있도록 분리시키는 최적의 초평면을 찾는 분류 모델

- Support Vector : 경계선에 있는 데이터

- SVM의 장단점

: 데이터가 적을 때 우수한 성능, 노이즈 데이터의 영향이 적음

: 단, 데이터가 많을 경우 인공신경망이 더 효과적임

- SVM의 파라미터

: C => 모델의 오류 정도의 허용

: Kernel => 차원을 바꿔주는 값

: 가중치 => 불균형한 데이터의 경우 가중치를 조정할 수 있음

=> KNN과 SVM은 데이터 스케일링이 필요함

Ch03-03 데이터 유형별 분류 알고리즘의 평가

1) Confusion Matrix

- 분류 모델이 가질 수 있는 결과를 매트릭스로 나타냄

- 정확도 / 민감도 / 예측을 수치화해서 나타낼 수 있음

- 예측과 민감도의 조화 평균을 사용한 F1Score를 사용하여 성능 측정

'패스트캠퍼스 > 딥러닝·인공지능Signature초격차패키지Online' 카테고리의 다른 글

| 패스트캠퍼스 환급챌린지 31일차 : Part3. 인공지능의 이해 Lv2 : 숲을 보는 인공지능 (0) | 2025.04.04 |

|---|---|

| 패스트캠퍼스 환급챌린지 30일차 : Part3. 인공지능의 이해 Lv2 : 숲을 보는 인공지능 (0) | 2025.04.03 |

| 패스트캠퍼스 환급챌린지 28일차 : Part3. 인공지능의 이해 Lv2 : 숲을 보는 인공지능 (0) | 2025.04.01 |

| 패스트캠퍼스 환급챌린지 27일차 : Part2. 인공지능의 이해 Lv1. 인공지능/딥러닝 파헤치기 (0) | 2025.03.31 |

| 패스트캠퍼스 환급챌린지 26일차 : Part2. 인공지능의 이해 Lv1. 인공지능/딥러닝 파헤치기 (0) | 2025.03.30 |